Esse algoritmo é racista? – a reflexão do sociólogo digital Rodrigo Saturnino

Quando pensamos na produção de algoritmos devemos pensar nas pessoas que os produzem, nas pessoas que dominam os lugares onde estes artefatos tecnológicos são construídos, assinala o sociólogo digital Rodrigo Ribeiro Saturnino, no texto “Esse algoritmo é racista?”*. No artigo, que integra o segundo número da MIL Magazine, o também activista gráfico e artista expõe “o grande abismo em termos de representatividade” demonstrado por uma análise realizada em 2019 pela CNBC sobre os indicadores da presença de funcionários negros nas maiores companhias de tecnologia do mundo.

Rodrigo Ribeiro Saturnino

Sociólogo digital, artista e ativista gráfico, atualmente trabalha como investigador Pós-Doc em Comunicação na Universidade do Minho, onde pesquisa o racismo algorítmico através de plataformas digitais. Entre as suas múltiplas publicações destacam-se o livro “A construção do imaginário social dos imigrantes brasileiros em Portugal nas redes sociais da internet: o caso do Orkut” (2016) e “A Política dos Piratas: Informação, culturas digitais e identidades políticas” (2017). É membro ativo na Djass – Associação de Afrodescendentes. No campo da arte, tem-se concentrado na crítica acerca de ideais criados sobre uma masculinidade colonial e racializada.

por Rodrigo Ribeiro Saturnino

Padrão. Essa é a principal palavra que rege o funcionamento de um algoritmo. Por defeito, um algoritmo funciona a partir de regras pré-estabelecidas por quem as escreveu, podendo, mais tarde, tornar-se autônomo na produção de novas regras baseadas nas originais. A ideia de “machine learning” (aprendizagem da máquina) parte do pressuposto de que o computador ou um dispositivo capaz de operar a partir das regras de um algoritmo adquire capacidade para construir novos modelos que utilizam a ideia de indução, ou seja, tal algoritmo seria informado o suficiente para extrair regras e padrões a partir de grandes bases de dados.

Mas nem sempre o padrão segundo o qual opera um algoritmo parte de uma regra justa. O padrão é estabelecido por uma regra social criada por pessoas – resta saber quem são as pessoas que constituem os padrões a serem seguidos por uma sociedade ou um algoritmo.

Basta pensar, por exemplo, na questão do binarismo social. Por muito tempo, a identidade de gênero ficou estagnada socialmente a partir de um modelo único de existência. Ser “homem” ou ser “mulher” cisgêneros ainda continua a ser um modelo identitário hegemônico que limita novas produções de visões do mundo. Por isso mesmo, padrões podem ser nocivos. O mesmo acontece com a produção algorítmica. Quando a construção de um algoritmo passa pela mão de uma pessoa constituída por valores sociais padronizados, corre-se o risco deste algoritmo reproduzir valores sociais que podem não estar alinhados com a justiça e a diversidade.

Nesse sentido, a questão racial é fulcral para compreender este processo e entender como uma situação de prejuízo criada no mundo offline foi transportada para o mundo dos algoritmos. Tal como a identidade de gênero hegemônica, podemos pensar na situação da hegemonia racial em que pessoas brancas têm operado os meios de produção a partir de modelos únicos.

Quando pensamos na produção de algoritmos devemos pensar nas pessoas que os produzem, nas pessoas que dominam os lugares onde estes artefatos tecnológicos são construídos. Uma análise realizada em 2019 pela CNBC sobre os indicadores da presença de funcionários negros nas maiores companhias de tecnologia do mundo revelou o grande abismo em termos de representatividade. Naquele ano, pessoas negras a trabalhar no Facebook representavam apenas 3,8%. No Twitter trabalhavam 6% e, na Amazon, havia 26.5% pessoas negras a trabalhar em centros de distribuição, longe de estarem em equidade com os postos ligados à engenharia de softwares.

A distribuição dos postos de trabalho no mundo da tecnologia deixa claro como este espaço é ainda dominado por homens cis brancos, geralmente oriundos de países com uma intensa história racista e colonial. No Brasil, um mapeamento denominado PretaLab, realizado em 2019 pela Olabi com o objetivo de estimular o protagonismo de mulheres negras e indígenas na inovação e na tecnologia, revelou que este setor é controlado em quase 60% por pessoas brancas, na maioria por homens cis heterossexuais.

Por que se sabe isso noutros países e não em Portugal? Porque ainda não existem políticas públicas no que toca às questões étnico-raciais e porque o debate sobre a inclusão das categorias que permitem identificar estes cidadãos ainda está longe de terminar. Outros países, como o Brasil e os Estados Unidos, estão muito mais avançados neste campo porque há muito que reconhecem o racismo como um elemento de destruição da equidade social e que a cor da pele ainda é um dado relevante na distribuição de postos de trabalhos em todos os setores.

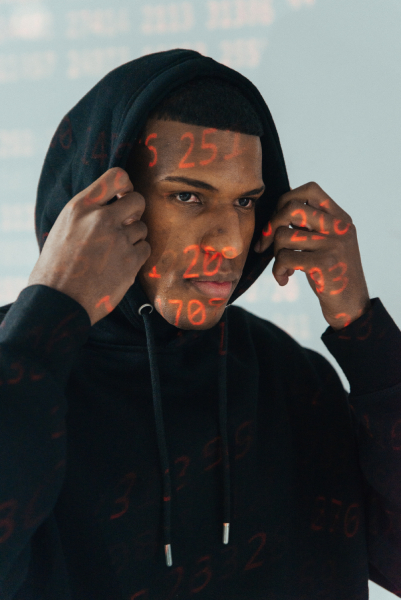

Para algumas pessoas, esta condicionante pode parecer um dado irrelevante. Mas não é. Pesquisas recentes, iniciadas a partir de 2010, demonstram que o funcionamento de alguns algoritmos replica condicionalismos sociais acerca da percepção sobre pessoas negras. No livro Algoritmos da Opressão (2018), Safiya Noble denuncia como a Google estava a permitir que pesquisas sobre “garotas negras” mostrassem resultados ligados à pornografia e à prostituição. Já Joy Buolamwini, fundadora do projecto Algorithmic Justice League (e protagonista do documentário da Netflix Coded Bias) identificou problemas nos algoritmos do software Rekognition, da Amazon, no que diz respeito ao reconhecimento facial: não eram eficazes na leitura de rostos de pessoas com peles escuras nem de mulheres.

A gravidade da situação acresce tendo em conta que este software tem sido utilizado por órgãos de policiamento urbano no controle de possíveis atos de criminalidade a partir das câmaras de vigilância nas ruas, contribuindo para reforçar a criminalização aleatória e sistêmica das pessoas não brancas.

O racismo digital instaurado pelas regras de certos algoritmos é complementado pelo comportamento de algumas pessoas dentro de plataformas online como a Uber, Airbnb, Glovo ou Blablacar. Nesses casos, não se trata exclusivamente de um padrão algorítmico, mas de uma tendência social que rejeita grupos sociais específicos.

Vários estudos já comprovavam que motoristas negros ou motoristas com nomes com raízes árabes e não-ocidentais, que normalmente não são considerados de pessoas brancas, ganham menos dinheiro e recebem menos pontuação positiva em comparação com motoristas brancos. O mesmo acontece com anfitriões negros do Airbnb. Entramos outra vez no papel do algoritmo destes aplicativos que, ao registar as análises dos consumidores, estabelece rankings que desfavorecem estas pessoas. Tendo menor pontuação, estes trabalhadores são considerados pelo algoritmo como pessoas de confiança duvidável e isso repercute-se na sua (des)estabilidade financeira. E não é assim que funciona o sistema racial na generalidade? Um sistema que desqualifica a pessoa a partir da desconfiança perante a sua humanidade. No caso destes aplicativos, temos os algoritmos operando em parceria com o comportamento social.

Não podemos ainda deixar de referir o quanto as redes sociais têm servido como plataformas de ódio. São muitos os casos de racismo através do digital, principalmente porque o caráter rizomático da internet dá força e coragem a quem a utiliza como espaço de prática de racismo, xenofobia e misoginia. Considerando que a rede é um espaço público de difícil regulação e que, com algum esforço criativo, é possível manter-se em anonimato, veículos como o Facebook, Instagram e Twitter têm servido de aporte para desencadear o ódio, mesmo com as medidas preventivas que têm surgido na tentativa de denunciar e controlar estes discursos. A subjetividade de quem trabalha na moderação de comentários e a falta de algoritmos capazes de rever palavras e imagens utilizadas em postagens não têm dado conta da tempestade de discriminações que pululam nas mensagens públicas e privadas a circular nestes espaços.

Como mudar todos estes cenários aqui explanados? Como promover alterações neste setor quando pensamos nos engenheiros de software que estão à frente destes meios de produção de dinheiro e de valor social? O que levaria estas pessoas, maioritariamente brancas, cis e heterossexuais, a se interessarem por questões raciais quando muitas delas negam a sua existência ou nunca pensaram sobre o assunto, considerando o privilégio que os mantém num lugar de conforto? Estamos diante de um quadro estrutural histórico de manutenção de um poder padronizado nas mãos de pessoas brancas. A tentativa das grandes empresas de tecnologia em incluir pessoas negras tem-se revelado um falhanço total. Quando vemos a Amazon reportar que nos seus quadros de trabalhadores há quase 30% de pessoas negras e percebemos que este percentual representa a força bruta da empresa, a gente também compreende que ninguém quer deixar o seu lugar de conforto e de poder para, de facto, dar lugar às pessoas historicamente desfavorecidas pelos contextos coloniais. Como será isso em Portugal? Como serão constituídos os lugares de decisão dentro das filiais das grandes empresas?

A questão que fica para refletir é: se uma pessoa com um lugar de poder não tem interesse em questões raciais porque entende que isso não a afeta, e provavelmente não afeta mesmo, o que a levaria a providenciar cenários de mudança? Talvez o começo da mudança aconteça aqui – quanto mais gente se levantar para debater a questão, quanto mais estudos forem feitos sobre o tema, quanto mais pessoas negres ocuparem espaços de poder na política, na cultura, no terreno empresarial. Quando se criarem categorias étnico-raciais para nos ser dado a conhecer onde estão pessoas como eu – pessoas negres portugueses e pessoas negres que vivem em Portugal – e quando se criarem cotas de reparação social a fim de tentar equilibrar injustiças que se perpetuam na história colonial portuguesa.

*“Esse algoritmo é racista?” integra o segundo número da MIL Magazine, publicação desenvolvida pelo MIL que pretende introduzir uma reflexão crítica sobre os tópicos que ocupam a actualidade do sector da música da cultura. O MIL é um festival dedicado à descoberta, valorização e internacionalização da música popular actual, que acontece nos dias 15, 16 e 17 de setembro no Hub Criativo do Beato. O lançamento da MIL Magazine n.º 2 acontecerá no dia 15 de setembro.